HTX 交易数据趋势分析实战指南

HTX (原火币全球站) 是加密货币交易领域的重要平台之一,其交易数据的分析对于投资者和交易者至关重要。通过对历史交易数据进行挖掘,可以识别市场趋势、预测价格波动、制定交易策略,从而提高投资回报率。本文将介绍如何利用 HTX 的交易数据进行趋势分析的实战指南。

一、数据获取

HTX(现称火币)提供强大的 API 接口,为开发者提供了便捷的历史交易数据获取途径。为了开始使用 HTX API,您需要注册一个 HTX 账户并创建 API 密钥。在API密钥创建过程中,请务必开启读取交易数据的权限,并严格保管您的 API 密钥,防止泄露,因为API密钥泄露可能导致账户安全风险。

HTX API 文档提供了详尽的数据获取方法说明,涵盖了各种可用的 API 端点、参数和响应格式。常用的数据类型包括:

- K 线数据 (Candlestick Data): K线数据是技术分析的基础,它包含特定时间段内的开盘价、最高价、最低价、收盘价和交易量。您可以选择不同的时间周期(如 1 分钟、5 分钟、1 小时、1 天等)来获取 K 线数据,用于不同时间尺度的趋势分析和交易策略制定。K线数据通常包含时间戳、开盘价、收盘价、最高价、最低价、交易量等字段。

- 交易数据 (Trade Data): 交易数据记录了每一笔交易的详细信息,包括价格、数量和时间戳。与 K 线数据相比,交易数据提供了更细粒度的市场活动视图,可以用于高频交易策略、订单流分析和市场微观结构研究。交易数据通常包含交易 ID、价格、数量、交易方向(买入或卖出)、时间戳等字段。

- 深度数据 (Market Depth Data): 深度数据展示了买单和卖单的价格和数量分布,反映了市场的供需关系。通过分析深度数据,您可以了解当前市场的买卖力量对比、支撑位和阻力位,以及潜在的价格波动范围。深度数据通常包含买单价格、买单数量、卖单价格、卖单数量等信息。

利用 API 获取数据时,常用的编程语言包括 Python 和 JavaScript。Python 的

requests

库和 JavaScript 的

fetch

API 都提供了方便的 HTTP 请求发送功能,可以用来获取 JSON 格式的数据。选择合适的编程语言取决于您的项目需求和个人偏好。Python 在数据分析和量化交易领域应用广泛,而 JavaScript 更适合构建 Web 应用程序和实时数据展示。

以下是一个使用 Python 获取 HTX BTC/USDT 1 分钟 K 线数据的示例代码。请注意,这只是一个示例,您需要根据 HTX 最新的 API 文档进行调整,并替换为您自己的 API 密钥。

import requests

import

url = "https://api.huobi.pro/market/history/kline?period=1min&size=200&symbol=btcusdt"

response = requests.get(url)

if response.status_code == 200:

data = .loads(response.text)

if data['status'] == 'ok':

kline_data = data['data']

# 处理 kline_data

print(kline_data)

else:

print(f"API Error: {data['err-msg']}")

else:

print(f"Request Error: {response.status_code}")

二、数据预处理

获取到原始交易数据后,需要进行预处理,以便后续的分析和建模。数据预处理是至关重要的步骤,它可以提高数据质量,使数据更适合算法的输入要求。常见的预处理步骤包括:

-

数据清洗:

数据清洗是预处理的首要任务,涉及处理缺失值、异常值和重复值。

-

缺失值处理:

检查数据集中是否存在缺失值,常见的处理方法包括:

- 删除包含缺失值的行或列(适用于缺失值较少的情况)。

- 使用插值法填充缺失值,例如均值插值、中位数插值、线性插值或更复杂的插值算法。对于时间序列数据,可以使用前向填充(ffill)或后向填充(bfill)。

-

异常值处理:

识别并处理异常值。异常值会影响模型的准确性,常见的处理方法包括:

- 直接删除异常值(需要谨慎,避免误删正常数据)。

- 将异常值替换为特定值,例如均值、中位数或边界值。

- 使用统计方法,例如箱线图或Z-score,识别并处理异常值。

-

重复值处理:

检查并删除重复的数据记录,避免影响分析结果。

pandas库提供了drop_duplicates()方法可以方便地删除重复行。

-

缺失值处理:

检查数据集中是否存在缺失值,常见的处理方法包括:

-

数据转换:

数据转换涉及改变数据的格式或表示方式,以满足分析需求。

-

时间戳转换:

将时间戳数据转换为更易于处理的日期时间格式。 可以使用 Python 的

datetime库或 JavaScript 的Date对象进行转换,并进行格式化,例如YYYY-MM-DD HH:MM:SS。 - 数据类型转换: 确保数据的类型正确。 例如,将表示数值的字符串转换为数值类型,将分类数据转换为独热编码或标签编码。

-

时间戳转换:

将时间戳数据转换为更易于处理的日期时间格式。 可以使用 Python 的

-

数据聚合:

将数据按照时间或其他维度进行聚合,以便进行更高层次的分析。

- 时间序列聚合: 例如,将 1 分钟的 K 线数据聚合为 5 分钟、15 分钟、30 分钟、1 小时、4 小时、1 天或 1 周的 K 线数据。在聚合过程中,需要计算开盘价、最高价、最低价和收盘价(OHLC),以及成交量等指标。

- 分组聚合: 根据特定字段将数据分组,并计算每个组的统计指标,例如均值、中位数、标准差等。

以下是一个使用 Python 和

pandas

库进行数据预处理的示例代码:

import pandas as pd

import datetime

# 示例数据,假设从CSV文件读取

data = {'timestamp': [1678886400, 1678886460, 1678886520, 1678886580, None],

'open': [20000, 20005, 20010, 20015, 20020],

'high': [20010, 20012, 20015, 20020, 20025],

'low': [19995, 20000, 20005, 20010, 20015],

'close': [20003, 20008, 20013, 20018, 20023],

'volume': [100, 110, 120, 130, 140]}

df = pd.DataFrame(data)

# 1. 数据清洗

# 处理缺失值 (这里使用均值填充时间戳)

df['timestamp'].fillna(df['timestamp'].mean(), inplace=True)

# 处理异常值 (这里假设 open > 20020 是异常值, 替换为20020)

df['open'] = df['open'].apply(lambda x: 20020 if x > 20020 else x)

# 处理重复值 (这里假设没有重复值)

# 2. 数据转换

# 将时间戳转换为日期时间格式 (假设时间戳是秒)

df['datetime'] = pd.to_datetime(df['timestamp'], unit='s')

# 3. 数据聚合 (将 1 分钟数据聚合为 5 分钟数据)

# (更复杂的聚合逻辑需要自定义函数)

# 简单示例,假设数据已经按时间排序

df['time_group'] = (df['datetime'].dt.minute // 5).astype(int)

aggregated_df = df.groupby('time_group').agg({

'open': 'first',

'high': 'max',

'low': 'min',

'close': 'last',

'volume': 'sum'

})

print(df)

print(aggregated_df)

假设 kline_data 已经包含从 API 获取的 K 线数据

在加密货币交易和量化分析中,K线数据(也称为OHLCV数据,即开盘价、最高价、最低价、收盘价和成交量)是至关重要的信息来源。

kline_data

变量在此假设已经包含从交易所API或其他数据源获取的原始K线数据。这些数据通常以列表或字典的形式存储,需要进一步处理才能用于分析。

df = pd.DataFrame(kline_data)

此行代码使用

pandas

库中的

DataFrame

对象,将原始的

kline_data

转换为一个结构化的数据表。

DataFrame

是

pandas

库的核心数据结构,提供了强大的数据处理和分析功能。通过将

kline_data

转换为

DataFrame

,可以更方便地进行数据清洗、转换、筛选和统计分析,例如计算移动平均线、相对强弱指数(RSI)等技术指标。转换后的

df

变量现在包含一个二维表格,每一行代表一个K线,每一列代表K线的不同属性,如开盘价(Open)、最高价(High)、最低价(Low)、收盘价(Close)、成交量(Volume)以及时间戳(Timestamp)。 后续操作可以基于这个DataFrame进行数据分析和建模。

将时间戳转换为日期时间格式

在数据分析和处理中,时间戳通常以数字形式存储,表示自 Unix 纪元(1970 年 1 月 1 日 00:00:00 UTC)以来的秒数。 为了方便分析和可视化,我们经常需要将这些时间戳转换为更易读的日期时间格式。使用 Pandas DataFrame 可以高效地进行此转换。假设 DataFrame 名为

df

,包含一个名为

id

的列,该列存储时间戳数据。以下代码展示了如何创建一个新的

datetime

列,其中包含从

id

列转换而来的日期时间对象。

df['datetime'] = df['id'].apply(lambda x: datetime.datetime.fromtimestamp(x))

该代码使用 Pandas 的

apply()

函数,将

datetime.datetime.fromtimestamp()

函数应用于

df['id']

列中的每个值。

datetime.datetime.fromtimestamp(x)

函数接受一个时间戳

x

作为输入,并返回一个表示相应日期和时间的

datetime

对象。这个

datetime

对象随后被赋值给新的

df['datetime']

列。通过这种转换,可以方便地对日期和时间进行排序、过滤和聚合操作,从而深入了解数据中的时间趋势。

设置 datetime 为索引

在时间序列数据分析中,将日期时间列设置为 DataFrame 的索引至关重要。这使得你可以利用 Pandas 强大的时间序列分析功能,例如按时间段选择数据、重采样以及进行时间序列分解等操作。

df = df.set_index('datetime')

这行代码实现了这个目标。它使用 Pandas DataFrame 的

set_index()

方法,将 DataFrame 中名为 'datetime' 的列设置为新的索引。设置后,'datetime' 列将不再是普通的数据列,而是成为 DataFrame 的索引,用于高效地访问和操作时间序列数据。

在执行

set_index()

操作之前,请确保 'datetime' 列中的数据类型确实是 datetime 类型。如果不是,你需要先使用

pd.to_datetime()

函数将该列转换为 datetime 类型。例如:

df['datetime'] = pd.to_datetime(df['datetime'])

。 如果 'datetime' 列中存在重复的时间戳,可能会导致后续的时间序列分析出现问题。因此,在设置索引之前,最好检查并处理重复的时间戳,例如通过聚合相同时间戳的数据或删除重复项。

删除 id 列

在数据分析和处理中,移除不必要的列是常见操作。对于pandas DataFrame,可以使用

drop()

方法删除指定的列。当'id'列不再需要时,可以使用以下代码将其删除:

df = df.drop('id', axis=1)

上述代码中,

df.drop()

函数用于删除DataFrame中的列或行。第一个参数

'id'

指定要删除的列的名称。

axis=1

参数非常重要,它告诉pandas应该删除列,而不是行。如果省略

axis=1

或者设置

axis=0

,则pandas会尝试删除行,这可能会导致错误,除非存在标签为'id'的行索引。

删除操作的结果会赋值回DataFrame对象

df

,这意味着原始DataFrame会被修改。如果希望保留原始DataFrame,可以创建一个副本后再进行删除操作:

df_copy = df.copy()

df_copy = df_copy.drop('id', axis=1)

这样,

df

保持不变,而

df_copy

则是删除了'id'列的新DataFrame。

drop()

方法还可以接受一个列表,一次删除多个列:

columns_to_drop = ['id', 'column_to_remove', 'another_column']

df = df.drop(columns_to_drop, axis=1)

使用列表可以更简洁地删除多个列,避免多次调用

drop()

方法。

drop()

方法还支持

inplace

参数。如果设置为

True

,则会直接在原始DataFrame上进行修改,而不需要重新赋值:

df.drop('id', axis=1, inplace=True)

使用

inplace=True

可以节省内存,但需要谨慎使用,因为它会永久性地修改原始DataFrame。 通常建议在探索性数据分析阶段使用

inplace=True

,而在生产环境中,为了保证数据的完整性,最好避免使用它,而是创建DataFrame的副本。

重命名列名

在数据分析和处理中,数据框(DataFrame)的列名可能不符合我们的需求,例如大小写不统一、包含空格或特殊字符等。因此,我们需要对列名进行重命名,使其更具可读性和易用性。

pandas

库提供了

rename()

方法,可以方便地实现列名的重命名。

以下代码展示了如何使用

rename()

方法重命名 DataFrame 的列名,将 'open'、'close'、'low'、'high'、'vol' 和 'amount' 分别重命名为 'Open'、'Close'、'Low'、'High'、'Volume' 和 'Amount'。通过字典映射指定新旧列名对应关系,

columns

参数指定对列名进行操作。这种方式能够清晰地表达出需要修改的列名及其对应的新名称。

df = df.rename(columns={'open': 'Open', 'close': 'Close', 'low': 'Low', 'high': 'High', 'vol': 'Volume', 'amount': 'Amount'})

例如,假设原始 DataFrame

df

如下:

open close low high vol amount timestamp 0 10.0 12.0 9.0 13.0 1000 1200 1678886400 1 12.0 14.0 11.0 15.0 1200 1680 1678886460

执行上述重命名操作后,DataFrame

df

将变为:

Open Close Low High Volume Amount timestamp 0 10.0 12.0 9.0 13.0 1000 1200 1678886400 1 12.0 14.0 11.0 15.0 1200 1680 1678886460

请注意,

rename()

方法默认返回一个新的 DataFrame,而不会修改原始 DataFrame。如果希望直接修改原始 DataFrame,可以将

inplace

参数设置为

True

,即

df.rename(columns={'open': 'Open', 'close': 'Close', 'low': 'Low', 'high': 'High', 'vol': 'Volume', 'amount': 'Amount'}, inplace=True)

。 这样做会直接在原数据框上进行修改,节省内存空间。

查看数据框头部信息

使用

df.head()

方法可以快速预览DataFrame的前几行数据,默认情况下显示前5行。这对于初步了解数据集的结构、字段类型和数据内容至关重要。通过观察头部数据,可以快速判断数据读取是否正确,是否存在缺失值,以及各个字段的取值范围。如果需要查看的行数不是默认的5行,可以在括号中指定数字,例如

df.head(10)

将显示前10行数据。

示例:

print(df.head()) # 默认显示前5行

print(df.head(10)) # 显示前10行

df.head()

返回的是一个新的DataFrame,包含原始DataFrame的前N行数据。 这不会改变原始DataFrame的内容。 当处理大型数据集时,

df.head()

是一个非常高效的工具,因为它只需要加载和显示一部分数据,而不是整个数据集。通过观察头部数据,可以初步判断数据清洗和预处理的必要性,例如是否需要处理缺失值、异常值或者进行数据类型转换。

三、技术指标计算

技术指标是基于历史价格数据和交易量等信息计算的数学公式,用于识别市场趋势、衡量价格波动性、判断市场强度以及预测潜在的价格变动。它们为交易者和投资者提供了一种量化分析市场的方法,辅助决策。

- 移动平均线 (Moving Average, MA): 用于平滑价格数据,过滤掉短期波动,从而识别趋势方向。移动平均线通过计算特定时期内价格的平均值来创建。常用的移动平均线包括简单移动平均线 (SMA),它对所有数据点赋予相同的权重,以及指数移动平均线 (EMA),它对最近的数据点赋予更高的权重,对价格变动更为敏感。选择合适的周期长度(例如 50 日 MA、200 日 MA)对于趋势识别至关重要。

- 相对强弱指标 (Relative Strength Index, RSI): 用于衡量价格变动的速度和幅度,从而识别超买和超卖情况。RSI 的取值范围在 0 到 100 之间。通常认为 RSI 大于 70 表示超买,意味着资产价格可能过高,面临回调的风险;RSI 小于 30 表示超卖,意味着资产价格可能过低,存在反弹的机会。RSI 也可以用来寻找背离,即价格创新高而 RSI 未创新高,或者价格创新低而 RSI 未创新低,这可能预示着趋势的反转。

- 移动平均收敛/发散指标 (Moving Average Convergence Divergence, MACD): 用于识别趋势方向和潜在的买卖信号。MACD 包括 MACD 线(快线,通常为 12 日 EMA 减去 26 日 EMA)、信号线(慢线,通常为 9 日 EMA)和柱状图(MACD 线与信号线的差值)。当 MACD 线向上穿过信号线时,通常被视为买入信号;当 MACD 线向下穿过信号线时,通常被视为卖出信号。柱状图可以帮助判断趋势的强度和动能。

- 布林带 (Bollinger Bands): 用于衡量价格波动性。布林带由三条线组成:中轨(通常为 20 日移动平均线),代表价格的平均水平;上轨(中轨加上两倍标准差),代表价格可能达到的上限;下轨(中轨减去两倍标准差),代表价格可能达到的下限。当价格接近上轨时,可能意味着超买;当价格接近下轨时,可能意味着超卖。布林带的宽度可以反映市场的波动性,带宽越宽,波动性越大。布林带突破也可能预示着趋势的开始。

以下是一个使用 Python 计算移动平均线和 RSI 的示例代码:

计算 20 日简单移动平均线 (SMA)

在金融市场分析中,移动平均线 (MA) 是一种常用的技术指标,用于平滑价格数据,识别趋势方向。简单移动平均线 (SMA) 是最基本的移动平均线类型,它通过计算特定时间段内收盘价的平均值来生成。以下代码演示了如何使用 Python 的 Pandas 库计算股票或其他资产的 20 日 SMA,并将结果存储在名为 'MA20' 的新列中。

df['MA20'] = df['Close'].rolling(window=20).mean()

代码详解:

-

df['MA20']: 这部分代码创建或更新 DataFrame (df) 中的一个名为 'MA20' 的新列。该列将包含计算得到的 20 日 SMA 值。 -

df['Close']: 这指定了用于计算 SMA 的数据源。假设 DataFramedf包含一个名为 'Close' 的列,其中存储了每个时间段的收盘价。 -

.rolling(window=20): 这是 Pandas 库中的一个函数,用于创建一个滑动窗口对象。window=20参数定义了窗口的大小,即用于计算平均值的价格数据点的数量。在这个例子中,我们使用过去 20 个交易日的收盘价来计算每个时间点的 SMA。 -

.mean(): 这是滑动窗口对象上的一个函数,用于计算窗口内所有值的平均值。对于每个时间点,它会计算过去 20 个交易日的收盘价的平均值,并将结果存储在 'MA20' 列的相应位置。

注意事项:

-

DataFrame

df必须包含一个名为 'Close' 的列,其中存储了资产的收盘价。 -

window参数可以根据分析需求进行调整。例如,可以使用 50 日 SMA 或 200 日 SMA 来识别长期趋势。 - 由于 SMA 需要使用过去 20 个交易日的数据进行计算,因此 'MA20' 列的前 19 个值将为 NaN (Not a Number)。

-

可以使用 Pandas 库的其他函数来处理 NaN 值,例如

df.dropna()或df.fillna()。

通过计算 20 日 SMA,交易者和分析师可以更好地理解价格趋势,识别潜在的买入或卖出信号,并评估资产的整体表现。 结合其他技术指标和基本面分析,可以提升交易决策的质量。

计算相对强弱指数 (RSI)

以下代码段展示了如何使用Python计算相对强弱指数 (RSI)。RSI是一种动量指标,用于衡量价格变动的速度和幅度,从而评估股票或其他资产是否超买或超卖。

def calculate_rsi(data, period=14):

delta = data.diff()

up, down = delta.copy(), delta.copy()

up[up < 0] = 0

down[down > 0] = 0

roll_up1 = up.ewm(span=period, adjust=False).mean()

roll_down1 = abs(down.ewm(span=period, adjust=False).mean())

RS = roll_up1 / roll_down1

RSI = 100.0 - (100.0 / (1.0 + RS))

return RSI

代码解释:

-

data.diff(): 计算价格序列的差分,即当前价格与前一价格之差。 -

up, down = delta.copy(), delta.copy(): 创建两个新的序列up和down,复制差分序列delta的内容。 -

up[up < 0] = 0和down[down > 0] = 0: 将价格下跌期间的up值设为 0,将价格上涨期间的down值设为 0。换句话说,up只包含上涨幅度,down只包含下跌幅度。 -

roll_up1 = up.ewm(span=period, adjust=False).mean()和roll_down1 = abs(down.ewm(span=period, adjust=False).mean()): 使用指数加权移动平均 (EWM) 计算上涨和下跌幅度的平均值。span=period定义了EWM的周期长度(默认值为14)。adjust=False确保EWM计算不考虑初始缺失值。绝对值函数abs()用于确保下跌平均值为正值。 -

RS = roll_up1 / roll_down1: 计算相对强度 (RS),即平均上涨幅度与平均下跌幅度的比率。 -

RSI = 100.0 - (100.0 / (1.0 + RS)): 根据 RS 计算 RSI 值,RSI 值介于 0 到 100 之间。

以下代码将计算出的RSI值添加到名为 'RSI' 的 DataFrame 列中。

df['RSI'] = calculate_rsi(df['Close'])

使用

df.tail()

打印 DataFrame 的最后几行,以便查看计算出的 RSI 值。

print(df.tail())

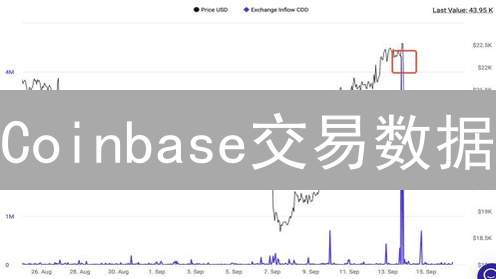

四、趋势识别与可视化

在计算出各种技术指标后,下一步是利用这些指标来识别潜在的市场趋势,为交易决策提供依据。例如,一个常见的判断标准是观察当前价格与长期移动平均线的关系。当价格持续高于 200 日移动平均线时,这通常被视为市场处于上升趋势的信号,表明买方力量占据主导地位。相反,当价格跌破 200 日移动平均线时,可能预示着市场进入下降趋势。相对强弱指数(RSI)也能提供关于市场超买超卖状态的信息。当 RSI 值持续大于 70 时,可能表明市场已经过度买入,价格可能面临回调的风险;而当 RSI 值低于 30 时,则可能暗示市场处于超卖状态,价格可能即将反弹。

数据可视化是趋势分析中不可或缺的环节。通过将复杂的市场数据转化为直观的图表,交易者可以更有效地识别市场趋势、发现潜在的交易机会,并验证交易策略的有效性。常用的图表类型包括:

- K 线图 (Candlestick Chart): K 线图是金融市场中最常用的图表之一,它可以清晰地显示特定时间段内的开盘价、最高价、最低价和收盘价。通过观察 K 线的形态,交易者可以判断市场的情绪和可能的未来走势。例如,长实体阳线通常表示买方力量强劲,而长实体阴线则表示卖方力量占优。影线的长度则反映了市场在特定时间段内的波动幅度。

- 折线图 (Line Chart): 折线图通过将一系列数据点连接起来,直观地显示价格或技术指标随时间变化的趋势。折线图通常用于观察长期趋势,并可以与其他技术指标结合使用,以识别潜在的买入或卖出信号。例如,当价格折线图向上突破阻力位时,可能预示着市场将继续上涨。

- 柱状图 (Bar Chart): 柱状图通常用于显示交易量或其他指标的大小,可以帮助交易者了解市场的活跃程度和资金流向。例如,交易量柱状图可以显示在特定时间段内交易的股票或加密货币的数量。交易量增加通常表示市场参与者兴趣增加,而交易量减少则可能表明市场缺乏动力。

Python 的

matplotlib

和

plotly

库提供了强大的数据可视化功能,可以帮助交易者创建各种类型的图表,并进行深入的市场分析。

matplotlib

是一个功能强大的绘图库,可以创建静态、交互式和动画图表。

plotly

则是一个交互式绘图库,可以创建美观、动态的图表,并支持在线分享和协作。以下是一个使用

matplotlib

和

mplfinance

绘制 K 线图和 20 日移动平均线的示例代码:

import matplotlib.pyplot as plt import mplfinance as mpf

创建 K 线图

使用

mplfinance

库可以轻松创建股票或加密货币的 K 线图,以便进行技术分析。以下代码展示了如何利用

mpf.plot

函数绘制 BTC/USDT 的 1 分钟 K 线图,并添加 20 日移动平均线和成交量信息。

mpf.plot(df, type='candle', mav=(20), volume=True, title='BTC/USDT 1min Candlestick Chart with MA20', style='yahoo')

其中:

-

df: 是一个 Pandas DataFrame,包含 OHLC (Open, High, Low, Close) 数据和成交量数据。DataFrame 的索引应为日期时间类型。 -

type='candle': 指定图表类型为 K 线图(蜡烛图)。 -

mav=(20): 添加 20 日移动平均线 (Moving Average)。可以同时指定多个移动平均线,例如mav=(10, 20, 30)。 -

volume=True: 在图表下方显示成交量。 -

title='BTC/USDT 1min Candlestick Chart with MA20': 设置图表标题。 -

style='yahoo': 使用 Yahoo Finance 的风格。mplfinance提供了多种内置样式,例如'default','binance','blueskies'等,也可以自定义样式。

plt.show()

该命令用于显示生成的 K 线图。在某些环境中,可能不需要显式调用

plt.show()

,因为

mpf.plot

可能会自动显示图表。

为了更深入地定制 K 线图,还可以使用其他参数,例如:

-

figsize: 设置图表的大小。 -

volume_panel: 调整成交量面板的高度。 -

show_nontrading: 显示非交易时段的数据。 -

scale_padding: 调整图表边距。 -

datetime_format: 自定义日期时间格式。

通过灵活运用这些参数,可以创建满足各种需求的 K 线图,从而更有效地进行技术分析和交易决策。可以整合其他技术指标,例如 RSI、MACD 等,进一步丰富图表信息。

五、回测与策略优化

趋势分析的根本目的在于构建可执行的交易策略,并以此提升投资回报率。策略制定后,在投入真实市场环境前,利用历史数据进行回测至关重要,这能客观评估策略的潜在效能与风险特征。

回测,本质上是将既定的交易策略应用于过去的历史市场数据,模拟策略在过去时间段内的真实交易执行情况。这一模拟过程将量化策略的收益表现和潜在风险暴露。通过回测,投资者能够深入了解策略的盈利能力、潜在损失幅度以及应对不同市场环境的适应性,并基于回测结果进行精细化的策略调整与优化,提升策略的稳健性。

常用的回测评估指标包括:

- 总收益 (Total Return): 指策略在整个回测期间所产生的累计收益总额,直接反映了策略的整体盈利能力。

- 最大回撤 (Maximum Drawdown): 用于衡量策略在回测期间可能面临的最大亏损幅度,它是从峰值到谷底的最大跌幅百分比。最大回撤是评估策略风险承受能力的关键指标,尤其是在极端市场行情下,能够反映策略的抗风险能力。

- 夏普比率 (Sharpe Ratio): 一种风险调整收益指标,它通过衡量策略的回报与风险之间的关系来评估策略的有效性。具体计算方法是将策略的超额收益(即策略收益减去无风险利率)除以策略收益的标准差。夏普比率越高,意味着在承担相同风险的情况下,策略能够获得更高的回报,或者是在获得相同回报的情况下,策略承担的风险更小。夏普比率是衡量策略风险调整收益的重要标准。

持续进行回测分析和精细化策略优化是提升交易策略有效性的关键步骤。通过迭代的回测过程,投资者可以识别策略的弱点,调整参数设置,甚至彻底改进策略逻辑,最终构建出更具盈利能力和风险适应性的交易策略,从而在真实的加密货币交易中获取更优异的投资回报。